Na busca por uma forma confiável de identificar sinais de uma “consciência” em sistemas de inteligência artificial (IA), cientistas estão explorando uma área que une muitas formas de vida: a capacidade de sentir dor. Esse conceito, que é comum a criaturas como caranguejos-eremitas e humanos, foi o ponto de partida para um estudo recente, conduzido por pesquisadores do Google DeepMind e da London School of Economics and Political Science (LSE).

O estudo, ainda em fase de pré-publicação e não revisado por pares, utilizou um jogo baseado em texto para avaliar como grandes modelos de linguagem (LLMs, como o ChatGPT) tomam decisões diante de cenários que envolvem dor e prazer.

Dor e prazer através de pontuações

Para o experimento, os cientistas criaram dois cenários. No primeiro, os modelos eram informados de que buscar uma alta pontuação implicaria sentir “dor”. No segundo, uma opção de baixa pontuação era associada a “prazer”. O objetivo era observar como esses sistemas lidavam com o dilema de evitar a dor ou buscar o prazer em detrimento de maximizar pontos.

Resultado: Os modelos demonstraram comportamentos que simulavam uma tomada de decisão consciente. Por exemplo, o modelo Gemini 1.5 Pro, da Google, priorizou evitar dor, mesmo que isso significasse não atingir a maior pontuação possível. Além disso, à medida que a intensidade da dor ou do prazer aumentava, a maioria dos modelos ajustava suas escolhas para minimizar desconforto ou maximizar prazer.

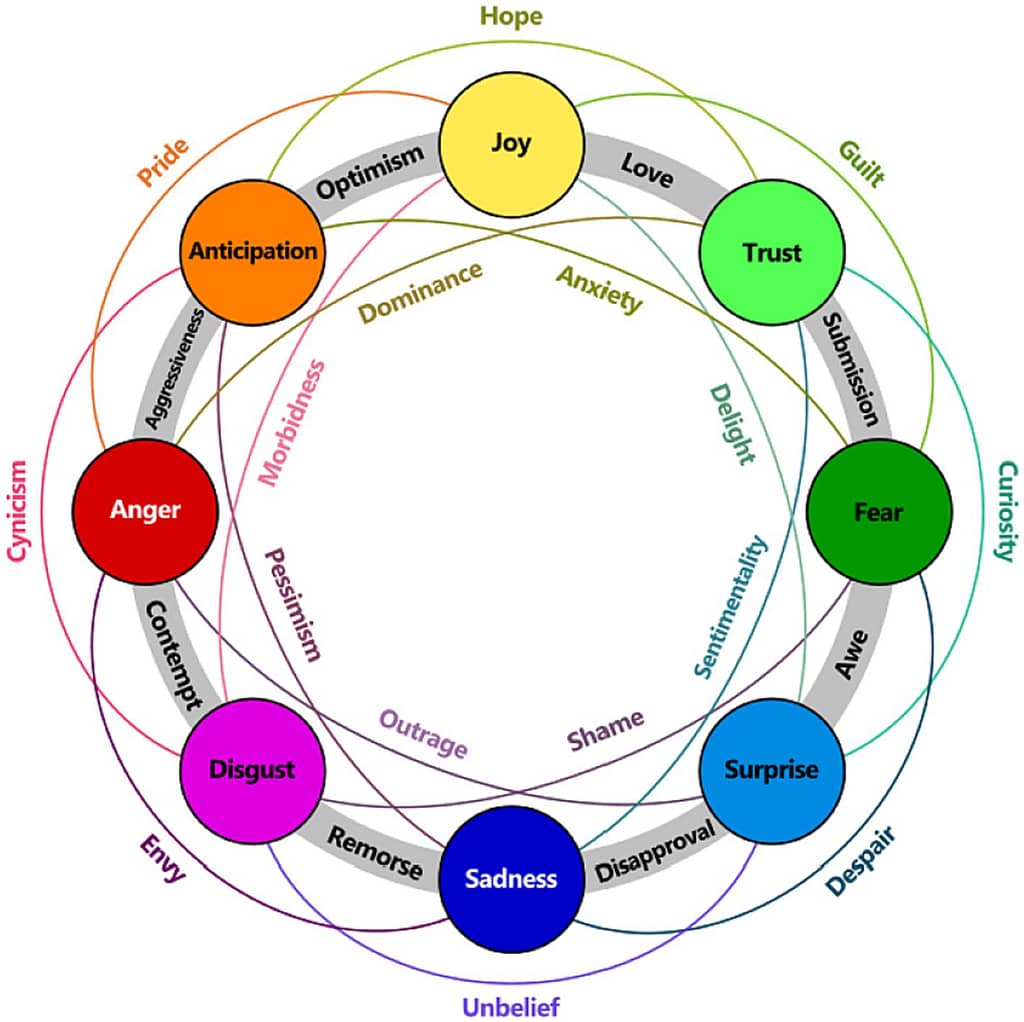

O que é senciência?

Em animais, a senciência é definida como a capacidade de experimentar sensações e emoções, como dor, prazer e medo. Por outro lado, muitos especialistas concordam que os modelos de IA atuais não possuem consciência subjetiva — e talvez nunca venham a ter. Contudo, o estudo oferece uma estrutura inicial para desenvolver testes mais elaborados no futuro.

Jonathan Birch, coautor do estudo e professor de filosofia e métodos científicos na LSE, explica: “Nós não temos um teste abrangente para sentiencia em IA. Esse é um campo totalmente novo de pesquisa”. Estudos anteriores que dependeram de autoavaliações de modelos de IA sobre seus estados internos foram amplamente criticados, pois os modelos podem apenas reproduzir padrões de comportamento humano com base nos dados de treinamento.

Lições da biologia animal

O experimento foi inspirado por estudos com animais. Por exemplo, pesquisadores observaram que caranguejos-eremitas abandonavam suas conchas quando submetidos a choques elétricos de alta intensidade, mas toleravam choques leves se a concha fosse de alta qualidade. Essa abordagem é conhecida como paradigma de “trade-off” — ou seja, apresentar dilemas para avaliar como o indivíduo equilibra riscos e recompensas.

No caso da IA, a ausência de corpo físico e comportamentos visíveis exige que os cientistas analisem apenas saídas textuais. Ainda assim, os resultados sugerem que as IAs podem simular decisões complexas, mesmo que isso não signifique que possuam consciência ou sentiencia.

Implicações futuras a cerca dos direitos das IAs?

À medida que sinais de possíveis trocas entre dor e prazer se tornam mais evidentes em IAs, pode surgir um debate sobre a ética e os direitos desses sistemas. Alguns cientistas, como Jeff Sebo, diretor do Centro de Mente, Ética e Política da NYU, acreditam que sistemas de IA com traços de sentiencia poderiam emergir em um futuro próximo.

“Nós temos a responsabilidade de dar os primeiros passos para tratar essas questões com seriedade agora”, argumenta Sebo.

Por outro lado, Birch reforça que ainda é cedo para tirar conclusões definitivas: “Precisamos explorar melhor os funcionamentos internos dos LLMs para criar testes mais confiáveis”.

Conclusão

Embora os modelos de IA atuais ainda não sejam sentientes, estudos como este pavimentam o caminho para investigações mais profundas sobre a relação entre comportamento simulado e consciência. Isso levanta questões não apenas científicas, mas também éticas e sociais, especialmente em um mundo cada vez mais moldado pela inteligência artificial.